애플, 아이폰서 ‘아동 성학대’ 사진 적발한다…사생활 침해 논란

- 08-06

- 1,985 회

- 0 건

아동에 대한 성적학대 이미지 식별하는 SW 개발

문제 사진 감지되면 검토 후 사법당국에 알릴 계획

다음달 美서 업데이트시 적용…사생활 침해 논란

5일(현지시간) 파이낸셜타임즈(FT) 등에 따르면 애플은 다음달 미국 사용자들에게 제공될 업데이트를 통해 아동에 대한 성(性) 학대 이미지를 담은 사진을 식별할 수 있는 소프트웨어(SW)를 도입할 계획이다.

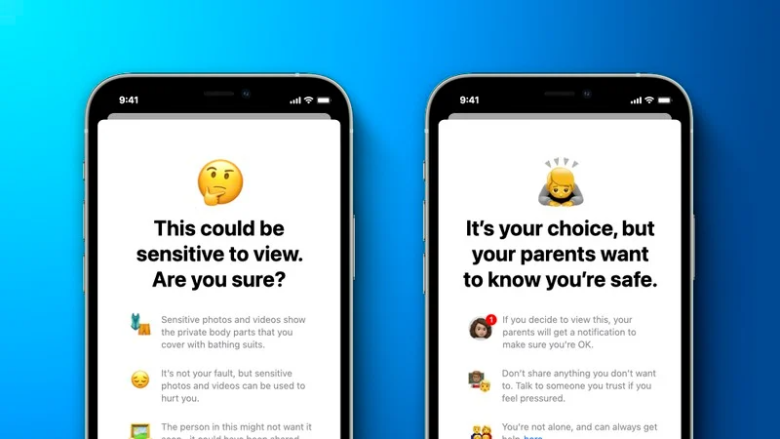

이 SW의 이름은 ‘뉴럴 매치’로 다음달 출시되는 아이폰 운영체제(OS) 최신 버전인 iOS15의 새로운 기능으로 추가된다. 인공지능(AI) 기능을 통해 아이폰에 저장된 이미지 중에서 아동에 대한 성적 학대로 의심되는 이미지를 포착하고, 검토팀에서 위법성을 적발하면 법 집행 기간에 연락하는 식이다. 해당 기능은 이미지에만 적용되며 동영상은 스캐닝하지 못 한다.

애플측은 “시간이 지남에 따라 진화하고 확장하는 새로운 아동 보호 시스템의 일부”라고 설명했다. 애플은 이번주 초 화상회의를 통해 이 프로그램을 일부 미국 학자들에게 상세히 설명했다고 FT는 전했다.

다만, 새로운 기능이 사생활 침해 여지가 있다는 비판도 제기되고 있다. 애플은 사생활 보호를 최우선 가치로 내세우며 경쟁사들과 차별화 되는 브랜드 이미지를 구축하고 있다.

애플측은 AI와 암호화 기술을 통해 이미지를 스캐닝하고 불법 이미지로 알려진 데이터 베이스와 일치하는 지 여부를 판독해 내는 것이라며 사생활 검열과는 다르다는 입장이다.

- 이전글 코로나 글삭튀한 닉 보시요 21.10.17

- 다음글 속보) 젊은층 문재인한테 등 돌려 21.07.31